Submitted by gouki on 2013, February 25, 11:29 PM

ubuntu下面有一个很不错的功能,它能够使你很方便 的添加ppa的源,那就是apt-add-repository

在我之前写的一篇博客里就有介绍此功能(关于gearman的),但在debian系统上就无法适用,因为debian下没有此功能

于是找了ubuntu下的apt-add-repository的代码,cp了一份到debian下面,但不能运行。所以google了一下,发现这么一段代码就OK了:

XML/HTML代码

- #!/bin/bash

- if [ $# -eq 1 ]

- then

- ppa_name=`echo "$1" | cut -d":" -f2 -s`

- if [ -z "$ppa_name" ]

- then

- echo "PPA name not found"

- echo "Utility to add PPA repositories in your debian machine"

- echo "$0 ppa:user/ppa-name"

- else

- echo "$ppa_name"

- echo "deb http://ppa.launchpad.net/$ppa_name/ubuntu lucid main" >> /etc/apt/sources.list

- apt-get update >> /dev/null 2> /tmp/apt_add_key.txt

- key=`cat /tmp/apt_add_key.txt | cut -d":" -f6 | cut -d" " -f3`

- apt-key adv --keyserver keyserver.ubuntu.com --recv-keys $key

- rm -rf /tmp/apt_add_key.txt

- fi

- else

- echo "Utility to add PPA repositories in your debian machine"

- echo "$0 ppa:user/ppa-name"

- fi

将这段内容存成apt-add-repository,然后cp到/usr/bin目录下,并且chmod +x 这个文件,让它有可执行的权限。

再接着使用apt-add-repository 来添加源就OK了

这个自定义的版本,在添加完源后,还会将source.list进行了修改。比ubuntu还人性化。。

参考:

1.http://cptbtptp.blog.51cto.com/3228046/620036

2.http://jolin.2001.blog.163.com/blog/static/89912172011485354567/

两篇内容细看,其实就是一样的。。

Tags: debian, ubuntu, apt, ppa

苹果相关 | 评论:3

| 阅读:34348

Submitted by gouki on 2013, February 22, 4:17 PM

其实,以前是用览易平台的,但好象很久没有更新了吧?

现在在使用游聚平台和SupARC

SupARC以前就是arclive,改名了

在平台上一般也就玩《真侍魂》,水平很烂,和朋友、同事们娱乐娱乐

游聚的速度快,但是和览易一样会有小问题:时间玩长了之后,会丢包,丢多了之后,两边会出现屏幕不一致的情况。这点suparc就不会

suparc对网速有点要求,但只要连接上了,就不会两边不同步。这点挺好

游聚的自动补斜最好不要打勾,否则有些招式比较难发。。

使用游聚平台的朋友,如果玩格斗的,还是注意一下下了。

Misc | 评论:0

| 阅读:19173

Submitted by gouki on 2013, February 21, 1:46 PM

如何学GO,如何用GO,如果整理思想,正好有几篇文章可以看一下

1.Danny.tian: 一步一步学习Revel Web开源框架

2.许式伟:Go,基于连接与组合的语言(上)

3. GAE教程:https://developers.google.com/appengine/docs/go/

开发的时候,有工具可以使用,国人开发的一款IDE

1.Go语言开发工具LiteIDE(作者采访)

2.http://code.google.com/p/liteide

还有一份GO Web开发教程,这一份流传的较广,但我不介绍了,这是infoQ的采访:

1.采访:关于Go语言和《Go Web编程》

一步一步往前走吧,真可恨自己的时间不够 .

| 评论:0

| 阅读:16378

Submitted by gouki on 2013, February 21, 1:41 PM

PD读取windows的时候还是比较方便的,在运行的时候也能将整个虚拟机共享出来,但linux就不行了..

pd mounter不是说用就能用的..只有在停止虚拟机的时候才能用,但这个时候,你mounter出来就没有意义了...

所以最简单的办法,还是samba一下吧.当然前两天我介绍的,将ssh整合到finder菜单也是一个办法.

1.samba :[2009-03-03] - 笔记:在Ubuntu中设置samba共享可读写文件夹

2.ssh with finder : How to Mounting FTP/SFTP volumes with the Finder

如果你在未开机状态下,可以参考这个官方的教程:http://download.parallels.com/desktop/v4/docs/en/Parallels_Desktop_Users_Guide/27290.htm

如果你的linux虚拟机额外挂了一个分区,那用这个教程可能会出点问题,重启系统即可以解决...(可能是BUG),磁盘会挂载出错

那如何共享你虚拟机里的磁盘呢?官方还有一个教程:

http://download.parallels.com/desktop/v4/docs/en/Parallels_Desktop_Users_Guide/22907.htm

至此,已经基本上可以正常使用了

Flutter | 评论:0

| 阅读:17249

Submitted by gouki on 2013, February 19, 6:39 PM

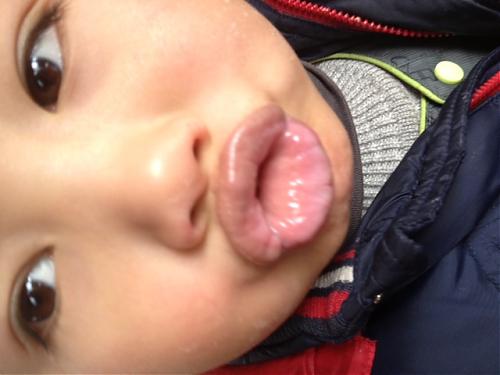

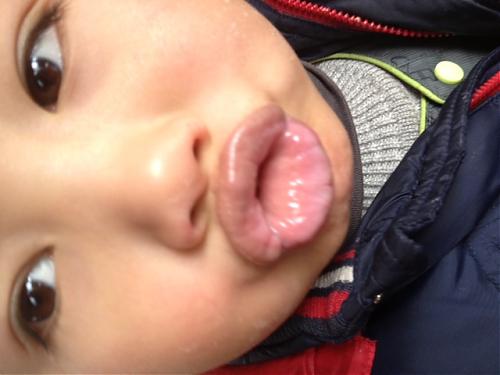

亲

Tags: 肖佑阳

Scala & Ruby | 评论:0

| 阅读:31725